大模型落地實戰(zhàn)指南 從選擇到訓練,打造AI應用新篇章

隨著人工智能技術(shù)的飛速發(fā)展,大模型已成為推動各行各業(yè)數(shù)字化轉(zhuǎn)型的關(guān)鍵工具。大模型的落地并非易事,涉及硬件選型、模型訓練與選擇等多個復雜環(huán)節(jié)。本指南將從實戰(zhàn)角度出發(fā),深度解析大模型落地的核心步驟,涵蓋顯卡選型、模型訓練技巧、模型選擇策略,并對AI未來進行展望,助力計算機軟硬件及外圍設(shè)備制造企業(yè)打造高效的AI應用。

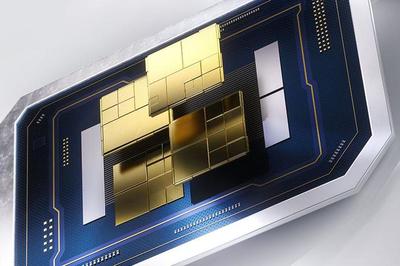

一、顯卡選型:硬件基礎(chǔ)決定模型性能

在大模型落地過程中,顯卡作為計算核心,直接影響訓練速度和推理效率。選擇合適的顯卡需綜合考慮算力、顯存、功耗和成本。目前,NVIDIA的A100、H100等專業(yè)級顯卡因其強大的并行計算能力和優(yōu)化的軟件生態(tài)成為首選。對于預算有限的企業(yè),RTX 4090等消費級顯卡也可作為替代方案,但需注意顯存限制。關(guān)鍵指標包括:FP32/FP16算力、顯存容量(建議至少24GB以上)、互聯(lián)帶寬(如NVLink)。應結(jié)合具體應用場景:例如,圖像處理任務(wù)可能更依賴高顯存,而自然語言處理則需要高算力支持。

二、模型訓練技巧:高效優(yōu)化與數(shù)據(jù)管理

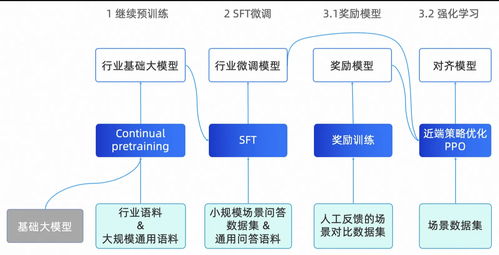

模型訓練是大模型落地的核心環(huán)節(jié)。數(shù)據(jù)預處理至關(guān)重要:需確保數(shù)據(jù)質(zhì)量,進行清洗、標注和增強,以提升模型泛化能力。采用分布式訓練策略可加速過程,例如使用Horovod或PyTorch DDP框架,結(jié)合多GPU并行。超參數(shù)調(diào)優(yōu)也不容忽視,可通過網(wǎng)格搜索或貝葉斯優(yōu)化方法找到最佳學習率、批大小等。遷移學習能大幅減少訓練時間和資源消耗,例如基于預訓練模型(如BERT、GPT系列)進行微調(diào)。監(jiān)控訓練過程,使用TensorBoard等工具可視化損失和準確率,及時調(diào)整策略以避免過擬合。

三、模型選擇巧:匹配業(yè)務(wù)需求與資源約束

模型選擇直接影響應用效果和成本。企業(yè)需根據(jù)業(yè)務(wù)場景(如語音識別、圖像分類或文本生成)選擇合適的大模型。例如,GPT系列適用于生成任務(wù),而ViT模型在計算機視覺領(lǐng)域表現(xiàn)優(yōu)異。關(guān)鍵考慮因素包括:模型大小(參數(shù)量)、推理延遲、準確率和可解釋性。對于資源受限的環(huán)境,可優(yōu)先選擇輕量化模型(如MobileNet或TinyBERT),或通過模型剪枝、量化技術(shù)壓縮模型。評估開源模型與自研模型的利弊:開源模型(如Hugging Face提供的模型)可快速部署,但自研模型更能滿足定制化需求。

四、AI未來展望:技術(shù)趨勢與行業(yè)應用

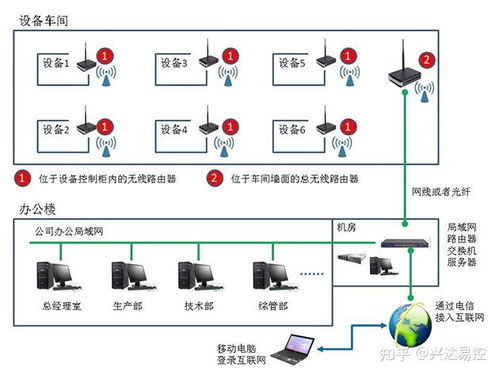

AI技術(shù)正朝著多模態(tài)、自適應和可解釋性方向發(fā)展。大模型將更注重跨領(lǐng)域融合,例如結(jié)合視覺與語言的多模態(tài)模型(如DALL·E)。在硬件方面,專用于AI的芯片(如TPU、NPU)將普及,提升能效比。對于計算機軟硬件及外圍設(shè)備制造業(yè),AI可用于優(yōu)化生產(chǎn)流程(如預測性維護)、提升產(chǎn)品質(zhì)量(如自動檢測缺陷),并推動智能設(shè)備(如AI攝像頭、機器人)的創(chuàng)新。倫理與法規(guī)也將成為焦點,企業(yè)需關(guān)注數(shù)據(jù)隱私和模型公平性,以實現(xiàn)可持續(xù)發(fā)展。

打造AI應用新篇章

大模型落地是一個系統(tǒng)工程,需硬件、軟件和數(shù)據(jù)的協(xié)同。通過科學選型顯卡、優(yōu)化訓練流程和精準選擇模型,企業(yè)可降低門檻,加速AI應用部署。隨著技術(shù)演進,AI將為計算機軟硬件及外圍設(shè)備制造帶來革命性變革,開啟智能化新篇章。建議企業(yè)持續(xù)學習最新技術(shù),構(gòu)建跨學科團隊,以應對未來挑戰(zhàn)。

如若轉(zhuǎn)載,請注明出處:http://m.dgdongjia.com.cn/product/8.html

更新時間:2026-01-09 12:31:09